从3D车道线到局部地图,BEV视角求解「路在何方」| Nullmax进化学

发布时间:2023-02-17BEV感知与车道线检测

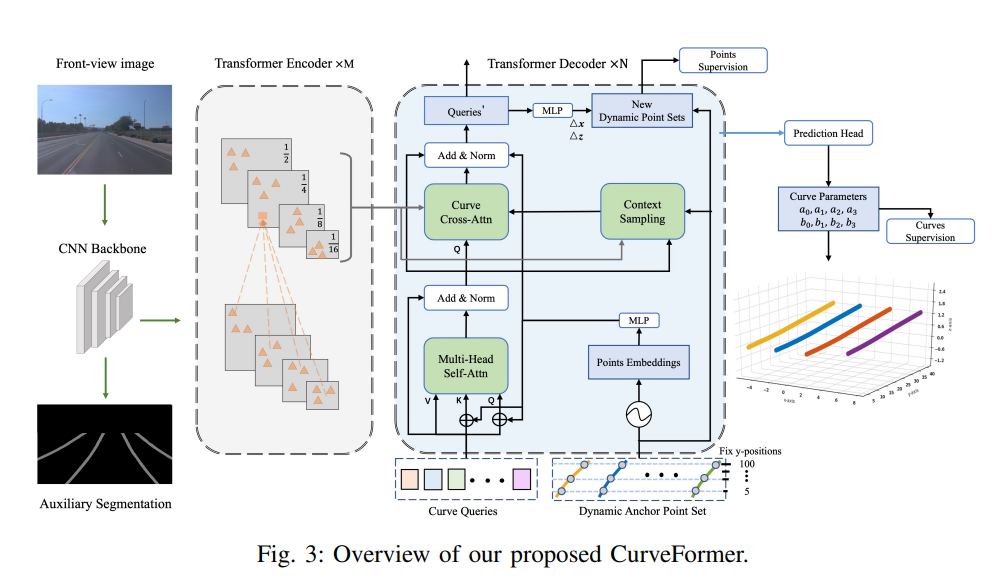

面向量产的3D车道线算法

在合成数据集和真实世界数据集上,CurveFormer与3D-LaneNet、Gen-LaneNet、PersFormer等优秀算法进行了对比,实验数据显示CurveFormer拥有非常全面的优异性能,优于其他算法。因此在量产应用中,CurveFormer也呈现出了巨大的落地优势,不仅任务效果出众,可以满足复杂城市道路等场景下的车道线检测要求,而且计算需求不大,可以部署到算力较低的量产计算平台之上。

在合成数据集和真实世界数据集上,CurveFormer与3D-LaneNet、Gen-LaneNet、PersFormer等优秀算法进行了对比,实验数据显示CurveFormer拥有非常全面的优异性能,优于其他算法。因此在量产应用中,CurveFormer也呈现出了巨大的落地优势,不仅任务效果出众,可以满足复杂城市道路等场景下的车道线检测要求,而且计算需求不大,可以部署到算力较低的量产计算平台之上。局部地图与全场景驾驶

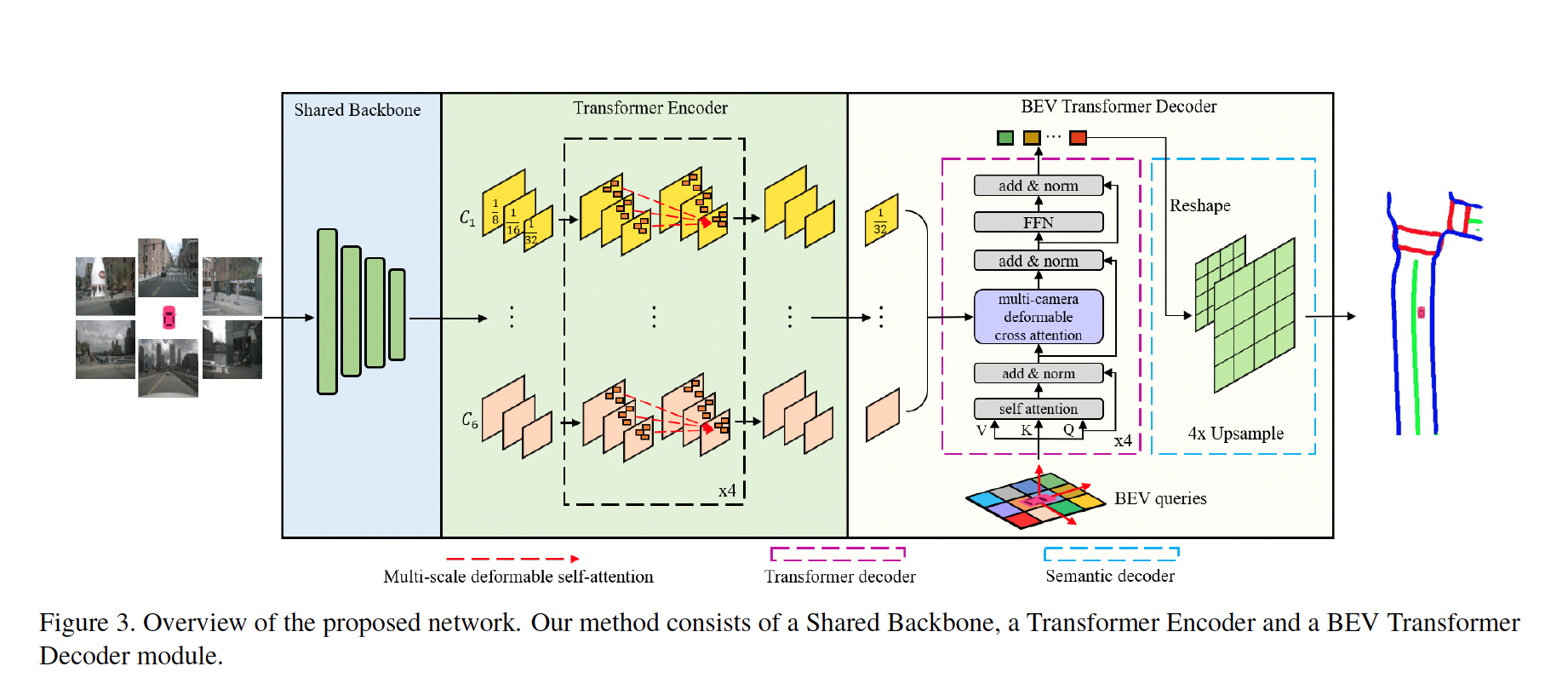

如今,随着BEV感知快速发展,BEV视角的语义分割、道路环境理解也成为了在线视觉建图的一个优先选项。它的优势在于可以很好地融合多个视角相机的图像,提取出丰富的环境信息,整体效果更加鲁棒。同时,BEV视角的语义分割也更方便和其他BEV视角的感知任务、规划任务整合,形成端到端的整体方案,进行全局的优化。

局部地图和其他地图相比,不仅关注地图信息的高精度,还尤为看重车端的实时性,因此这也对算法提出了很高的要求。

行业顶尖的BEV语义分割

这一基于Transformer的BEV语义分割方法,同样也取得了当下业界最优(SOTA)的算法效果,论文入选计算机视觉学术会议WACV 2023。BEVSegFormer相比于HDMapNet等优秀算法,性能提升超过了10个百分点。

结语

媒体垂询

media@nullmax.ai相关文章

- 高效交付有章法,Nullmax量产工程深度解析 2024-04-19

- 打造智驾「新质生产力」,Nullmax BEV-AI技术架构带飞上分! 2024-03-28

- 入选CVPR 2024!Nullmax 提出多相机3D目标检测新方法QAF2D 2024-02-27

- 创新不停步,Nullmax感知论文获旗舰期刊RA-L录用 2024-01-18

- Nullmax出席2023全球自动驾驶峰会 揭秘BEV-AI技术架构加速量产方案演进 2023-12-22